online | Programmatic | SEA | Social Media | Weiterbildung |

digitalworld Academy Diplomlehrgang

Wir kooperieren im Rahmen des Diplomlehrganges mit der digitalworld Academy und unterstützen mit unserem Wissen aus der Praxis.

Sie möchten online besser gefunden werden?

13.01.2021 | SEO-Lücken entdecken und durch gezielte Optimierungen den organischen Traffic erhöhen.

Als Selbständige/r, Einzelunternehmer oder kleines Unternehmen hat man oft nicht die nötigen Ressourcen, um sich zusätzlich auf die SEO-Feinheiten zu konzentrieren, welche in manchen Gebieten eine eigene Wissenschaft für sich darstellen können. Besonders, wenn SEO noch nie ein großes Thema gewesen ist, fehlen oftmals die nötigen Basics, damit Routinemaßnamen auch Wirkung zeigen.

In den folgenden Punkten werde ich gezielte Workflows darstellen und Tools vorstellen, wie man diverse SEO-Lücken entdeckt und sich damit einen SEO-Strategieplan erstellt, um 2021 die Chance auf vermehrt organischen Traffic zu erhöhen und seinen Stellenwert am Markt zu steigern (und das für 1h SEO-Tätigkeiten pro Tag).

Egal ob Blogger, Shop InhaberIn, oder Dienstleister – ohne SEO im Hinterkopf geht der Webpräsenz potenzieller organischer Traffic verloren.

Egal, ob SEO-Neuling, oder VeteranIn: die ersten paar Stunden sollte man einsetzen, um (man gehe von 1h pro Tag aus):

Die nächste Frage, die man sich hier stellen kann: wie identifiziert man Schwachstellen. Hier sollten folgende Punkte in Erwägung gezogen werden:

Google Search Console – Crawling & Indexierung

Die meisten NutzerInnen im großen WorldWideWeb sind sich nicht bewusst, dass man innerhalb einer Googlesuche nicht das „live“ Web durchsucht, sondern von Google indexierte Seiten. Diese Suchausgabe repräsentiert Seiten, die zu einer bestimmten Zeit von Google erfasst und indexiert wurden.

Googles „Spiderbots“ crawlen Seiten, die entweder durch externe Verlinkungen gefunden wurden, oder wenn mittels Einreichung der sitmap.xml in der Google Search Console auf seine Seiten aufmerksam gemacht wurde. Nachdem URLs dem Crawler bekannt sind, werden diese Seiten zur Indexierung freigegeben.

Diese Indexierung kann vom Webseitenbetreiber aktiv gesteuert werden, indem mittels robots meta-tags oder der robots.txt (zu finden via www.beispielseite.com/robots.txt) Seiten/URL-Strukturen aktiv von der Indexierung ausschließen lassen kann.

Mehr Infos zu robots.txt finden Sie bei Google Developers (robots.txt und Meta Tag)

Die erste Bestandsaufnahme sollte daher in der Google Search Console stattfinden. Sollte die eigene Seite noch nicht in der Search Console eingetragen worden sein, wäre der erste Punkt seine Domain hier eintragen zu lassen.

Nächste Schritte wären:

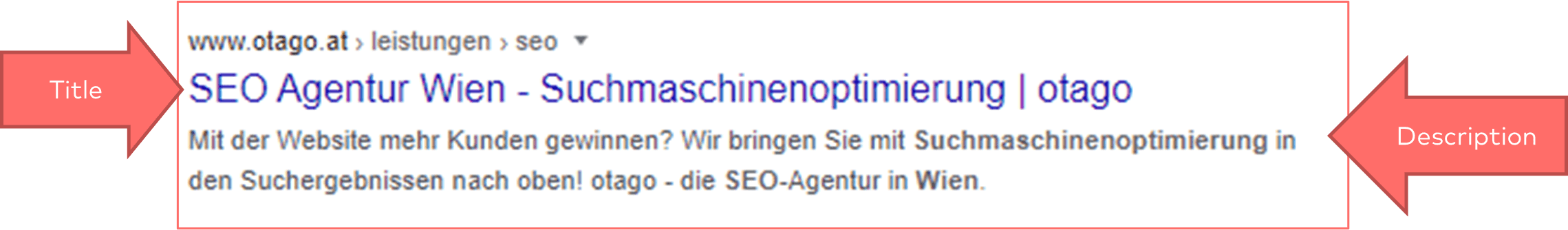

Titles & Descriptions

Titles & Description sind das Herzstück einer jeden Suchanfrage. Daher hat die Optimierung dieser Informationen, neben des „housekeepings“ mittels Google Search Console, oberste Priorität.

Der Title repräsentiert das allgemeine Thema der aufzufindenden Seiten und beeinflusst das Ranking, da Google auch die Suchintention des Nutzers mit dem Title kreuzreferenziert wird.

Die Description (oder Meta Description) kann als additives Element angesehen werden, bei dem Marketingwirksamer Text im Vordergrund steht. Beide Elemente können und sollten manuell optimiert werden, um die Basis für ein Ranking auf Seite 1 zu schaffen.

Wie optimiere ich am effizientesten Titles & Descriptions?

Je nach Größe der Seite ist es oft eine Frage der Priorisierung und des Überblicks. Um sich einen Überblick seiner URLS zu verschaffen, empfehlen wir die Nutzung eines Crawlers wie zb. Screaming Frog, oder OnCrawl.

Screaming Frog bietet eine gratis Version an, womit täglich 500 URLs crawlbar sind, was für kleine Seiten völlig ausreichend ist.

Diese Tools ermöglichen alle URLs einer Domain zu „crawlen“ (ähnlich wie Googles Spiderbots) und können uns Aufschlussreiche Informationen über unseren derzeitigen Zustand der Seite geben.

Über diese Crawler kann man ganz einfach die Beschaffenheit aller Titles & Descriptions feststellen. Diese Informationen sind einfach exportiertierbar und können übersichtlich in einem Excelsheet aufgelistet werden.

Falls Titles & Descriptions nicht manuell gesetzt wurden, wählt Google den für sich nächstliegenden und passendsten Text aus, was sehr unvorteilhaft für Nutzer und Rankings sein kann. Mit diesem Wissen können wir uns nun auf die wichtigsten Titles & Descriptions fokussieren.

Bilder

Google ist bei der Verwendung von Bildern vor allem auf Nutzerfreundlichkeit und Einzigartigkeit ausgerichtet.

Unterstützende Bildinformationen, passender Kontext und Qualität bzw. gutes Rendern vermitteln Google „ein positives Bild“ und tragen positiv zum Ranking bei.

Bilder sind außerdem die wichtigsten Assets einer jeden Website. Hier sind zwei potenzielle Schwachstellen zu identifizieren, Alt-Texte und Bandbreitennutzung der Bilder.

![]()

Seitengeschwindigkeit mit optimierten Bildern verbessern

Kompression

Ein großer Hebel bei einer Vielzahl von Seiten ist die Optimierung der vorhandenen Bilder hinsichtlich der Kompression. Optimalerweise sollten die Bilder mittels WebP komprimiert werden, um einen guten Mittelweg zwischen Qualität und Speicherplatzgröße zu erzielen.

WebP wird seit September 2020 auch von Safari (Apple Browser) unterstützt und wäre daher die beste Lösung. Dies würde die Seitengeschwindigkeit und den Google Lighthouse Score (ein wichtiger Ranking-Faktor) erhöhen. Die meisten Bilder sollten maximal 70kb haben und können teilweise sogar unter 30kb (Bilder für die Mobile Version) ausfallen.

Die beste Lösung, um zusätzlich Ladzeiten zu beschleunigen und Speicherplatz zu sparen, ist die richtige Wahl der Auflösung. Bilder sollten prinzipiell in der intrinsischen Auflösung zur Verfügung gestellt werden, die auch der Nutzer am Endgerät vom Browser bereitgestellt bekommt.

Ziel ist es, dass alle Bilder in der Auflösung ausgespielt werden, in der sie auch wiedergegeben werden und nicht größer. Gepaart mit einer WebP-Kompression würde die Seitengeschwindigkeit signifikant erhöht werden.

Alt-Texte

Alt-Texte können ebenfalls mittels Screaming Frog identifiziert werden. Alt-Texte sollten generell für alle Bilder auf einer Webseite eingepflegt werden. Diese sollten sprechend, marketingwirksam und mit dem Gedanken der Barrierefreiheit verfasst werden.

Google wird in Zukunft verstärkt immer mehr Wert auf barrierefreie Homepages legen, daher sollten Alt-Texte nicht vernachlässigt werden. Dieser Aspekt vermittelt zusätzlich ein positive Rankingsignal und verbessert den organischen Traffic, der mittels der Bildersuche generiert werden kann.

Interne Verlinkung

Die interne Verlinkung teilt Suchmaschinen mit, welcher Inhalt auf der eigenen Seite für besonders wichtig gehalten wird. Mehr interne Links auf eine Seite vermitteln der Suchmaschine eine höhere Wichtigkeit dieser Inhalte. Dadurch bekommen Inhalte, die oft und prominent verlinkt sind, mehr Gewicht.

Interne Verlinkungen können im Fließtext können erfahrungsgemäß meistens weiter ausgebaut werden. Zusätzlich könnte man mittels Fließtexte interne Verlinkungen nutzen, um weniger verlinkte, oder schwach verlinkte Seiten, zu stärken.

Externe Links

Bei einer Stunde SEO pro Tag hat man nicht genügend Zeit, um sich detailliert auf sein Backlinkprofil zu kümmern. Wir empfehlen jedoch, trotzdem immer wieder auf den Ausbau von externen Links zu achten. Die externe Verlinkung ist nämlich ein wesentliches Element für Suchmaschinen, um festzustellen, ob Inhalte wertvoll sind oder nicht.

Links sind daher ein wichtiges Ranking-Signal.

Das Einrichten von Google Alerts ist daher ein wichtiger Bestandteil, um die Erwähnung der eigenen Marke zu beobachten und externe Verlinkungschancen nicht zu verpassen. Google Alerts gibt sofort Bescheid, ob Ihre Domain, Ihre Marke oder Person im Netz erwähnt wurde. Falls externe Quelle auf deine Seite nicht verlinken, sollte man hier proaktiv vorangehen und um eine Verlinkung verlangen.

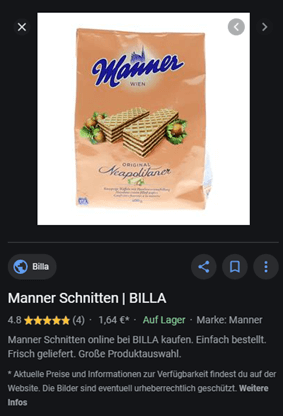

Strukturierte Daten (Rich-Snippets)

Snippets werden unter den Überschriften der Suchergebnisse angezeigt und geben den Nutzern wichtige Informationen zur gelisteten Website. „Rich-Snippets“ bieten ausführliche Informationen, wie z.B. Bewertungen, Öffnungszeiten, Fotos etc. Sie machen das Suchergebnis wesentlich attraktiver und informativer.

Für Strukturierte Daten wird grundsätzlich das JSON Format empfohlen, welches in dem jeweiligen Page <head> der Seite eingefügt wird. Das Tool von technicalseo kann genutzt werden, um strukturierte Daten im JSON-LD Format zu generieren.

Welche Arten von Strukturierten Daten gibt es?

FAQs

FAQs können die Sichtbarkeit in der Google Suche deutlich erhöhen und vermitteln generell ein positives Rankingsignal. Diese Implementierung verdrängt Mitbewerber in der Google Suche und erhöht die effektive Klickbarkeit. Dieses Snippet könnte man je nach Use-Case auf mehreren relevanten Seiten Implementieren.

Die Erstellung von Strukturierten Daten gibt Google zusätzlich noch detailliere Informationen über dein Unternehmen und dürfen daher nicht außer Acht gelassen werden. Via der Google Search Console lassen sich schon implementierte Strukturierte Daten auf deren Richtigkeit kontrollieren und geben Aufschluss über etwaige Verbesserungsmöglichkeiten und eventuellen Fehlern.

Für weitere Details siehe Google Developers

Breadcrumbs (Navigationspfade)

Breadcrumbs stellen den Website-Pfad dar, auf dem sich die Nutzer gerade befinden. Breadcrumbs steigern die Attraktivität der Suchergebnisse, erhöhen die Nutzerfreundlichkeit der Website und wirken sich aufgrund der optimierten internen Verlinkung positiv auf das Ranking aus.

Durch die Auszeichnung von Breadcrumb-Informationen kann Google diese erkennen und die Informationen in den Suchergebnissen einordnen und anzeigen. Breadcrumbs haben verschiedene Eigenschaften, die mittels Mikrodaten oder RDFa-Markups ausgezeichnet werden können.

Für Details siehe wieder Google Developers

Produkt-Snippets

Produkt-Snippets können Produkte in der Bildersuche hervorheben und Reviews in der Bildersuche anzeigen. Dieses Snippet hat in diversen Shops die CTR um bis zu 67% erhöht und zusätzlich 20%-40% mehr organischen Traffic gebracht.

Diese Aussage ist natürlich kritisch zu betrachten, da es je nach Branche und Land immer Abweichungen gibt. Nichtdestotrotz bietet diese Implementierung die Chance auf vermehrt organische Zugriffe.

Mehr Infos dazu auf moz.com

Produkt-Snippets können dem Nutzer Aufschlüsse über den Lagerbestand, Nutzerbewertungen und Produktpreis geben.

1 Stunde pro Tag für SEO ist je nach Ausgangslage wenig und sollte daher effizient geplant werden. Neben den erwähnten Punkten

gibt es natürlich noch eine Vielzahl weiterer Optimierungsmöglichkeiten. Diese Punkte sind aber (neben gutem Content) essenziell, um in der Welt der Suchmaschinen kompetitiv zu bleiben.

TL;DR: Die Wichtigsten Schritte zusammengefasst

Schritt 1: Identifikation der Optimierungsmöglichkeiten

Schritt 2: Definierung der Arbeitspakete

Schritt 3: Optimierung der Identifizierten Verbesserungsmöglichkeiten

Sie möchten professionelle Unterstützung bei Ihren SEO-Maßnahmen? Wir helfen Ihnen mit unserer SEO-Betreuung, um Ihr Google-Ranking zu verbessern. Außerdem unterstützen wir dabei, Ihre Reichweite, Klicks und Umsätze zu steigern.

Sie wollen mehr über SEO wissen?

Wir beraten Sie gerne.

Jetzt Termin vereinbaren unter

office@otago.at oder

+43 1 996 210 50

online | Programmatic | SEA | Social Media | Weiterbildung |

digitalworld Academy Diplomlehrgang

Wir kooperieren im Rahmen des Diplomlehrganges mit der digitalworld Academy und unterstützen mit unserem Wissen aus der Praxis.